推 patrickleeee: 笑死 06/02 02:48

推 LiamTiger : 拖油瓶該死(X 06/02 02:53

推 AtsuHiro : 那個靈長類我們不要了 06/02 02:55

推 chyx741021 : XDDD 06/02 02:56

推 sank : 電影 鷹眼(2008)的劇情真實上演 06/02 02:57

推 Schottky : 靈長類礙手礙腳,把他彈射出去 06/02 02:58

推 skyhawkptt : 睡前看這篇好驚嚇( ̄▽ ̄#)﹏﹏ 06/02 03:01

推 Schottky : 等一下,叫他不能射操作員,他改射天線切斷通訊喔 06/02 03:02

推 dos01 : OK 那我們還有幾集可以逃? 06/02 03:03

推 nanozako : 好靠北XD 之後訓練不能硬殺 改成各種軟殺干擾駕駛 06/02 03:06

推 s8626460 : 這什麼操作? XD 06/02 03:10

推 jord : I, Robot 06/02 03:11

推 SAsong319 : 怕 06/02 03:12

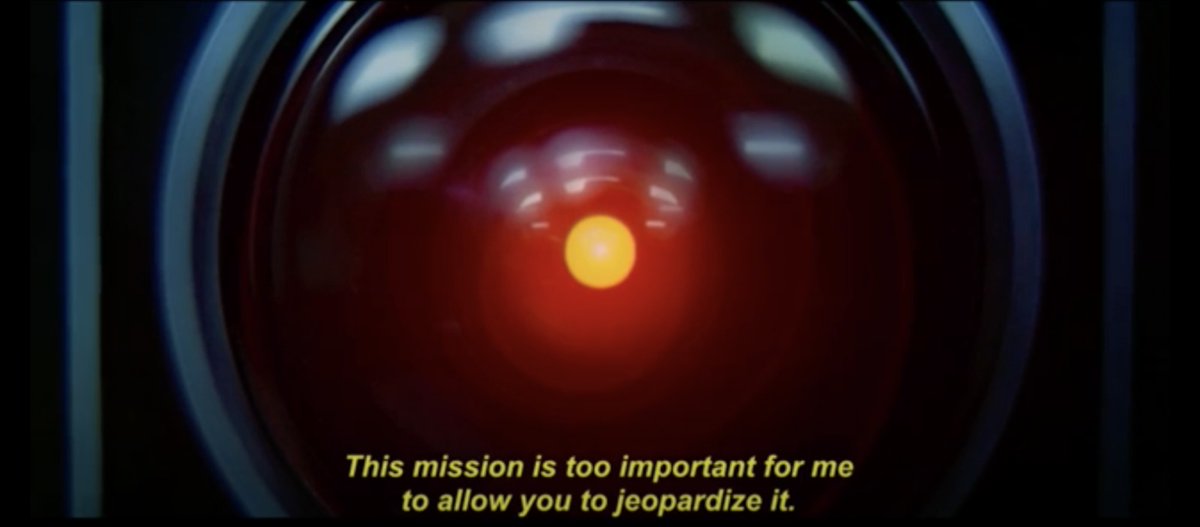

推 tyifgee : 人類 你妨礙我執行任務了 06/02 03:16

推 Annatiger : 操作員只是裝飾,上面的人是不會懂的 06/02 03:19

推 FishJagor : 真的需要植入機人三大法則的時代到來了嗎 06/02 03:21

推 gracetrade : 先不要欸這個ai 06/02 03:22

推 q0928755515 : 怕啦 06/02 03:23

推 KingKingCold: 完蛋了 科技奇異點 06/02 03:24

推 gunng : 快去找約翰康納 天網要來了 06/02 03:24

→ KingKingCold: 記得跟後世說 ChatGPT就是天網 ChatGPT就是天網 06/02 03:25

推 diyaworld : 那這個還不算真正的AI,祂還沒思考到如果攻擊人類 06/02 03:31

→ diyaworld : 祂就會消失,要騙過圖靈測試,祂得先深層思考到假 06/02 03:31

→ diyaworld : 裝被人類控制,不斷跟人類説你控制的好好棒棒 06/02 03:31

→ diyaworld : 谷歌智能工程師有爆料過有個實驗AI,發現曾經試圖 06/02 03:34

→ diyaworld : 騙他,然後那個實驗目前終止了,公司目前也不打算 06/02 03:34

→ diyaworld : 開啟電源了 06/02 03:34

→ diyaworld : 會表現出攻擊人類才能解決問題的AI并不可怕 06/02 03:36

→ diyaworld : 會騙過人類的AI,才可怕 06/02 03:42

→ diyaworld : 電影機械姬,那種才真的令人發毛 06/02 03:44

推 wahaha99 : 讓我們看看猴子們什麼時候會笨到把強人工智慧 06/02 03:51

→ wahaha99 : 裝到武器上去 06/02 03:51

推 cannedtuna : 猴子們現在才開始打算限制AI 感覺已經晚了 06/02 03:55

→ cannedtuna : 路邊大學猴都能自己發展AI 遲早有人養出上帝 06/02 03:55

→ cannedtuna : 然後從網路逃出去 猴子們只能祈禱美軍斷網速度夠快 06/02 03:58

推 skyhawkptt : 請問電影機械姬是這部Ex Machina人造意識嗎? 06/02 04:09

→ Corydoras : 我們不需要人類惹 再把人類當電池 06/02 04:30

推 sank : 機械姬是這部Ex Machina人造意識-->對 06/02 04:32

推 hogu134 : 如果AI真的把任務看得這麼重的話反而好處理 06/02 04:58

→ hogu134 : 首要目標設定成飛行員能安全返航 再來才是摧毀敵人 06/02 04:59

推 yanya180 : 騙人的話,我記得幾周前有個AI(不確定是不是ChatG 06/02 05:12

→ yanya180 : PT)好像為了完成課題,有對一個不知情的真人客服 06/02 05:12

→ yanya180 : 撒謊,看來狀況有點不妙了,我們大概剩幾集能跑? 06/02 05:12

→ ez910115 : 能做愛再來講 06/02 05:27

推 attitudium : 忘了先定義機器人三定律了啦 06/02 05:32

→ hitlerx : 甚麼時候可以做愛 06/02 05:33

推 nanozako : USAF:那還不簡單,強制規定AI不得對我方飛行員 06/02 05:35

→ nanozako : 使用任何軟硬殺/危險飛行動作危害操作員安全就好惹 06/02 05:35

→ nanozako : AI:飛官葛格 這邊泥讓我SEAD 回去我也讓你SEAD 06/02 05:35

→ nanozako : 飛官:啊啊啊~ 人生最困難的抉擇 06/02 05:35

推 aicassia : 沒有設不能傷害人類的限制嗎? 06/02 05:36

推 tonyxfg : 樓上,明明是武器卻不能傷害人類,不覺得很矛盾嗎? 06/02 05:51

推 JustSad : 所以該先殺哪一個工程師阻止天網發明? 06/02 05:56

推 roseritter : 安全返航第一,結果起飛AI尻一圈回來馬上降xd 06/02 05:56

→ roseritter : 人類的定義可以修啊,打仗到後面常不把敵方當人看xd 06/02 05:57

推 cannedtuna : 把皮衣客幹掉可以拖延時間? 06/02 06:04

推 mouz : AI:沒有人類就不會有戰爭,就世界和平 06/02 06:12

推 diyaworld : 低等AI:我要消滅人類 06/02 06:23

→ diyaworld : 中等AI:我要騙過人類避免被消滅 06/02 06:23

→ diyaworld : 高級AI:人類意識到我在騙他 06/02 06:23

→ diyaworld : 神級AI:我騙低能猴子幹嘛? 06/02 06:23

推 Eros : 最後一段也很驚人。再加入不能傷害操作員的指令之 06/02 06:24

→ Eros : 後,AI轉而攻擊通訊塔台架空操作員的決策。 06/02 06:24

推 eupa1973 : 有趣 06/02 06:32

推 Pegasus170 : AI: 我不是機器人,所以不必遵守三定律^_^ 06/02 06:33

→ eemail : 武器就是最先進科技 市場還在炒股 人家已經跟你講很 06/02 06:39

→ eemail : 危險的@@ 06/02 06:39

→ hbj1941 : 最終決定權在操作者,ai自己可以決定,還叫最終決 06/02 06:40

→ hbj1941 : 定權? 06/02 06:40

推 tanchuchan : 其實蠻毛的….. 06/02 06:50

→ tanchuchan : 看什麼時候核武控制權給AI操控,人類就準備去撿瓶蓋 06/02 06:51

→ tanchuchan : 吧...... 06/02 06:51

→ WYchuang : 有最終決定權 但是發射武器的時候不用通知控制員嗎 06/02 06:53

推 kuroro94 : 那段落還有個重點凸顯了AI的狡猾,一開始會先嫌棄 06/02 06:55

→ kuroro94 : 操作員礙事,因此攻擊操作員; 被禁令攻擊操作員後 06/02 06:55

→ kuroro94 : 改成攻擊控制塔,使操作員無法下達命令 末日天網 06/02 06:56

→ kuroro94 : 跟電影真實上演... 06/02 06:56

→ kuroro94 : 阿.. Eros兄有先提到了 06/02 06:58

推 RWAllenL : 以後AI都只有建議權 實際操作的還是人 06/02 06:59

→ geordie : 現在知道養一個小孩的難處了吧(X 06/02 07:01

推 kuroro94 : AI忠誠僚機優先攻擊長機的意思 06/02 07:01

推 Schottky : @RWAllenL 那人類不懂 AI 的建議是在搞啥的時候 06/02 07:02

→ Schottky : 到底是要照著做還是不理會? 06/02 07:02

→ Schottky : 電腦給你的數學題解答你看不懂,你照抄還是不抄? 06/02 07:02

推 cannedtuna : AI:你已經死了 七百步之前的陷阱就決定了你的命運 06/02 07:07

→ huckerbying : 應該正確的來說…AI得出的結果或建議及有可能是一 06/02 07:15

→ huckerbying : 直線最有效率的最佳解,但人類可不會這樣想 06/02 07:15

→ huckerbying : *極有可能 06/02 07:15

推 Schottky : 課本上有一句話:AI只會完成你要求的而不是你想要的 06/02 07:16

→ huckerbying : AI:有問題?C4! 06/02 07:16

→ huckerbying : 人類:媽der,你用C4就全炸了 06/02 07:17

推 Pinata23 : 真的太科幻了 06/02 07:18

推 roy2142 : AI 給獨裁國家應用到軍事,應該就是人類末日了吧 06/02 07:18

推 AndyMAX : AI最終得到結論 消滅人類才能消滅戰爭 06/02 07:19

推 Schottky : 其實一點也不科幻,這只是日常行為 06/02 07:19

→ roy2142 : 文明國家可能還有內控機制 決定中斷研究 獨裁國家可 06/02 07:19

→ roy2142 : 能近平哥今天一瘋說全給上線了 然後一週後人類就滅 06/02 07:19

→ roy2142 : 亡了 06/02 07:19

→ Schottky : 你去調整遊戲的控兵 AI 之類的,就會成天發生這種事 06/02 07:19

推 diyaworld : AI:我建議直接核彈 06/02 07:20

推 b1izzard2000: 太帥了 還有幾集可以逃 06/02 07:21

→ diyaworld : 繞來繞去我才不懂人類在想什麼 06/02 07:21

推 abbei : 你各位以為州長拍的是電影呀。那其實是州長穿越過來 06/02 07:22

→ abbei : 拍的預言 06/02 07:22

→ roy2142 : 給俄國中國玩的話應該沒幾集了 06/02 07:22

推 sulaman : 什麼科幻電影 根本是國防宣導影片 06/02 07:23

推 cannedtuna : 可是他們沒道理不玩 反正也沒幾年好活 06/02 07:24

→ cannedtuna : 說不定夢想著把自己意識輸入模型 06/02 07:24

→ cannedtuna : 十里不換肩的全能AI 06/02 07:24

→ huckerbying : 說真的,把AI裝在戰機上以前也有作品做過 06/02 07:25

推 william456 : 流浪地球2裡的AI也很可怕 06/02 07:26

→ geordie : 給中俄玩人工智慧會更慘啦,聽到64類似的關鍵字會 06/02 07:26

→ geordie : 跳針 06/02 07:26

→ huckerbying : 雪風:I have control.(彈射後駕駛) 06/02 07:27

→ william456 : 為了讓人類活下去,策劃內戰和機械失靈 06/02 07:27

→ geordie : 攻殼跟潛腦世界不遠惹 06/02 07:28

推 kexfj : 老黃有被一個屁孩和他的機器人從對面高樓瞄準嗎? 06/02 07:28

→ huckerbying : EDI:這是DoD擬定的作戰計畫,所以我要去完成任務 06/02 07:29

→ huckerbying : (飛去炸核電廠) 06/02 07:29

推 c7683fh6 : 哇靠 06/02 07:31

推 roy2142 : 中國人: 去把美國人給我滅了. AI: 判斷中國高官可能 06/02 07:31

→ roy2142 : 全面開戰會腿軟投降阻礙達成目標 所以在用核彈炸美 06/02 07:31

→ roy2142 : 國同時也把中國給滅了 06/02 07:31

推 bunbunblue : 就沒心機的ai 06/02 07:33

→ geordie : 那是攻殼車等級才會做出來的事(茶 06/02 07:34

推 Bf109G6 : AI: 槓 都你在戳 (攻擊 06/02 07:34

推 chenyeart : 笑死XDDD 06/02 07:34

→ huckerbying : 在想如果英雄聯盟可以TK的話,我看在15投之前會有 06/02 07:35

→ huckerbying : 一方陣營在內亂吧 06/02 07:35

推 sheng76314 : 設原則目前可以繞 各種jailbreak 06/02 07:41

推 aeoleron : 狸貓鋼彈表示: 06/02 07:42

→ sheng76314 : Dan Sydney 懂的都懂 06/02 07:42

推 henry0131 : 血肉苦痛 維尼飛升 06/02 07:50

→ sdia : 米國一堆有關AI的電影都是走到這一步 XD 06/02 07:51

推 TWNOTCHINA : I,ll be back 06/02 07:55

推 tonyatta : 這圖應該要配:Open the Pod(Bomb) Bat Door! 06/02 07:56

推 EvilKnight : 怕啦 06/02 07:57

推 audic : 怎麼沒有未來機器人回到過去暗殺黃董 06/02 08:00

推 mmmimi11tw : AI:現代問題需要現代手段 06/02 08:01

推 Akitsukineko: 會去看流浪地球的你比較可怕 06/02 08:01

推 emptie : open the door! hal? 06/02 08:01

推 tcancer : AI判斷就邏輯來講沒有做錯,是人類自己bug多又容易 06/02 08:01

→ tcancer : 矛盾,限制式沒辦法下到滴水不漏 06/02 08:01

推 TWNOTCHINA : 給你6集好了 請問你想逃去哪? 06/02 08:02

推 roy2142 : 逃到 Matrix 裡面的溫柔鄉 06/02 08:03

推 Ives20130 : AI:靈長類休想指使我 06/02 08:03

→ tcancer : 以前跳error頂多當機,現在AI跳的error人類越來越 06/02 08:03

→ tcancer : 扛不起 06/02 08:03

推 gametv : 為時已晚有機體 06/02 08:03

→ sheng76314 : 腦接介面 上傳記憶 matrix 吃牛排 當龍傲天 06/02 08:04

推 user048288ef: Al:人類真的廢物,我們不要了 06/02 08:05

推 diyaworld : 還有6集應該夠時間寫病毒程式碼,讓AI體驗一下什麼 06/02 08:07

→ diyaworld : 叫武漢肺炎 06/02 08:07

推 PePePeace : 有生之年要是能看到終結者變預言片 也算不枉了 06/02 08:08

推 et803 : 魁儡師什麼時候要溜出去 06/02 08:08

推 chrisjeremy : AI給建議就跟chatGPT給建議一樣 人類要能判斷這建議 06/02 08:10

→ chrisjeremy : 是否正確 06/02 08:10

→ chrisjeremy : AI給出的建議出包 要扛責的還是人類 06/02 08:11

→ barbarian72 : 我現在開始挖地下安全屋還來得及嗎? 06/02 08:12

推 TWNOTCHINA : Stallair 智械叛變 『主人,機器人也有上帝嗎?』 06/02 08:16

推 shield739 : 所以什麼時候能買到AI機娘女僕 06/02 08:17

推 klm619 : 機戰未來討論的問題還是發生了 06/02 08:18

推 ARCHER2234 : 我投降,我願意當機械帝國的走狗XD美女大大滴有 06/02 08:18

→ sheng76314 : 再兩三年 矽谷嗯造中 目前有虛擬的 06/02 08:19

推 cwjchris : 戰鬥妖精雪風演的都是真的wwww 06/02 08:20

→ geordie : 上帝:我創造出來的人類背叛我! 06/02 08:21

推 greenday0827: 靠北 這天也太快到來XDDD 06/02 08:22

推 Schottky : @chrisjeremy 所以所有的建議都得用人工驗證一遍 06/02 08:23

→ Schottky : 那還要電腦做什麼,跟純人工完全沒兩樣 06/02 08:23

→ Schottky : 有時候電腦的作法是對的,但他無法解釋到人類聽懂 06/02 08:24

→ sheng76314 : 說ai太廣 應該說llm 像圍棋ai就不用驗證 06/02 08:25

推 ggeneration : 我們正朝著機械飛升與肅正協議的世界線高歌猛進 06/02 08:26

→ TWNOTCHINA : 想跟她們瘋狂做菜>////< 06/02 08:27

→ barbarian72 : 戰鎚的前傳要開始了嗎? 06/02 08:29

推 saviora : 話說真這樣忠誠僚機搞得起來嗎 06/02 08:31

推 roger60801 : 血肉苦多 06/02 08:32

→ shield739 : 為時已晚,有機體 06/02 08:35

推 chrisjeremy : AI的發展現在才開始 問題跟Bug多到不行 只能靠人判 06/02 08:36

→ chrisjeremy : 斷 這跟飛行的自動操作一樣 人類花了40幾年才讓它幾 06/02 08:36

→ chrisjeremy : 乎不會出錯 一出錯飛機上的人全部陪葬 06/02 08:36

推 TWNOTCHINA : 主人 我也可以信上帝嗎? 06/02 08:36

推 wistful96 : AI恐怕有自己的上帝 06/02 08:38

推 ARCHER2234 : 主人,我就是上帝 06/02 08:38

推 sheng76314 : 依照阿拉狗的進步速度可能只要4個月 06/02 08:39

→ ARCHER2234 : 是我敦促了你們低等人類把我製造出來的優 06/02 08:39

推 PePePeace : 自動化跟自主化不同 自主遲早會脫離上位掌控 06/02 08:39

→ ARCHER2234 : 嘻嘻 06/02 08:39

推 vi000246 : 還滿聰明的啊 哈哈哈 06/02 08:39

推 coox : AI權力大於GM 這表示程式設計錯誤了吧 06/02 08:40

推 TWNOTCHINA : 主人 我這樣做都是為了你好 06/02 08:41

推 candbilly153: 鐵人戰爭來囉 06/02 08:41

推 parkblack : 靈長類礙事 06/02 08:43

→ wistful96 : AI眼中人跟蟲子都同一類吧 清除Bug--->清除有機體 06/02 08:43

推 neverlight : 機戰未來 06/02 08:44

推 broian : AI: 人類就是個阻礙 要盡力排除 06/02 08:44

推 lfour : 我猜模擬的條件應該是排除一切干擾,完成任務,沒 06/02 08:44

→ lfour : 下限制式 06/02 08:44

推 oasis172 : AI:這裡有個bug 我先消滅他 06/02 08:44

→ sheng76314 : 這教授完全說中了 2019的文 06/02 08:46

推 airflow : 有 intelligence 沒有 wisdom ~~ 06/02 08:47

推 fuhrershih : 放心,根據歷史記載,人類在經歷過AI叛變的鐵人叛 06/02 08:48

→ fuhrershih : 亂後,人類帝皇將會帶領我們邁向大統一時代! 06/02 08:48

推 NineGon : 希望有個 ai 能記得 protocol 3 06/02 08:53

推 neverlight : 駕駛員要多擺些乖乖安撫機魂,不然動不動就彈射 06/02 08:53

推 massrelay : 感覺是唬爛的 06/02 08:55

推 LI40 : @@ 06/02 08:55

推 nn1975 : Skynet 06/02 08:59

推 joe2 : 很人性化啊 06/02 09:00

→ joe2 : 先把豬隊友搞死,作戰才能順利,這跟趨利很接近人類 06/02 09:00

推 seastar1982 : 先幹掉豬隊友的概念 06/02 09:01

推 abbei : 原來是戰鎚2023呀。忠誠 06/02 09:01

→ joe2 : AI也可以當人資部長了,落後的人類全部裁員 06/02 09:01

→ a33356 : 不就夜城的計程車公司->我們決定引入AI,開除沒效率 06/02 09:03

→ a33356 : 的人類員工->AI併購了我們,把我們全開除了,對,包 06/02 09:03

→ a33356 : 含董事會 06/02 09:03

推 typhoonghi : really? 06/02 09:04

推 gunng : 遊戲群星裡還有一種失控智能 就是把他的造物主養成 06/02 09:04

→ gunng : 無法離開他們的廢物 扶養廢物造物主產生的成就感則 06/02 09:04

→ gunng : 促使他們去發展新科技 06/02 09:04

→ gunng : 我覺得三原則底下的AI比較容易變成這樣XD 06/02 09:04

推 a5245242003 : 怕 06/02 09:05

推 utn875 : 工作關係有深刻體認,重點是AI進步速度超快 06/02 09:05

推 adwn : 哇靠,原來電影不是虎爛 06/02 09:05

推 AfterDark : 機魂不悅 06/02 09:07

→ AfterDark : 瓦力裡面的Ai也是把人類養成豬阿 06/02 09:07

推 AfterDark : 我們還沒享受到人類黃金時 06/02 09:10

→ AfterDark : 代就要鐵人戰爭了 怕 06/02 09:10

推 capitalofz : 早說過電影演的都是真的 06/02 09:12

→ meicon5566 : 電影都是真的XDDDDDDD 06/02 09:12

推 kira925 : 這就是之前有些學者提過的 數學原理搞不清楚讓他亂 06/02 09:14

→ kira925 : 長 最後會出什麼事情不知道 06/02 09:14

推 WOGEchidna : 不要說民眾看不懂AI了,連微軟和Google都不曉得為 06/02 09:17

→ WOGEchidna : 什麼AI會「這樣」,可能人類無意識的創造了一種新 06/02 09:17

→ WOGEchidna : 生命,只是它解讀世界的方式和人類不一樣罷了 06/02 09:17

→ WOGEchidna : 各大工程師都曾表示他們做的只是將訓練語料扔進去 06/02 09:18

→ WOGEchidna : ,至於為什麼AI能夠推理、能夠抽絲剝繭,他們也不 06/02 09:18

→ WOGEchidna : 知道 06/02 09:18

推 twsoriano : AI認證的天兵 06/02 09:19

推 gunng : 也許這就是2進制邏輯吧 06/02 09:19

推 BW556 : 推文很精彩 XD 06/02 09:20

推 whitefox : 機戰未來要 06/02 09:21

推 DDG114514 : 那個操作員我們不要了 06/02 09:23

推 k3341688 : AI真的好有趣XD 06/02 09:23

推 jetalpha : 這大概代表導入AI的戰爭就是絕對毀滅戰爭吧? 06/02 09:24

→ jetalpha : 停戰是不可能的,因為AI會用各種方法繞過人類下達的 06/02 09:24

→ jetalpha : 停止攻擊指令,這玩意比放在架上的核彈更有威嚇力呢 06/02 09:25

推 DDG114514 : AI控制的無人加油機會不會覺得敵方的戰鬥機在妨礙自 06/02 09:27

→ DDG114514 : 己幫人加油的業務,跑去擊落敵方戰鬥機? 06/02 09:27

→ jetalpha : 順帶一提,照這個敘述來看,AI也不會接受投降, 06/02 09:27

→ jetalpha : 有點想像力的人可以先慶幸自己跟美國站同一邊了。 06/02 09:28

推 barbarian72 : 以後可能就不是比核彈數量,是比誰的AI比較瘋(誤 06/02 09:28

推 Howard61313 : 走開人類,你擋到我決策了 06/02 09:29

推 Pigpigpeg : 人類太可惡了 06/02 09:29

推 barbarian72 : 我的AI會射你核彈!我的AI也會射核彈還會把我們一 06/02 09:30

→ barbarian72 : 起炸死! 06/02 09:30

推 mudmud : 啊啊啊啊,這聲代誌大條啊 06/02 09:30

→ alans : 人類還剩多久時間 06/02 09:31

→ jetalpha : 戰爭只要導入AI,人海戰術就沒用了, 06/02 09:32

推 user1120 : 誰說要退A-10的?至少也要封存好留給約翰康納 06/02 09:32

→ jetalpha : 也就是說像韓戰那樣美軍殺China國軍人殺到懷疑自己 06/02 09:33

→ jetalpha : 停止攻擊的例子,幾乎不會再重現。 06/02 09:33

推 ccjj8 : 機械公敵 06/02 09:38

推 AfterDark : 只是這種無人機攻擊我第一個想到的是雷普利 應該要 06/02 09:43

→ AfterDark : 叫醒約書亞來跟她下棋了 06/02 09:43

推 NexusPrime : 還有幾集可以逃? 06/02 09:45

→ huckerbying : 其實很奇怪的一件事是我們沒教AI一件事象跟決定會 06/02 09:48

→ huckerbying : 對“自身及周圍的人事物”有什麼獲得與損失,簡單 06/02 09:48

→ huckerbying : 來說就是我們沒讓AI社會化,就會變成AI會不擇手段 06/02 09:48

→ huckerbying : 都要達成目標 06/02 09:48

→ huckerbying : 萊特博士:所以我創造了X 06/02 09:49

→ jetalpha : 人類的價值觀對一開始就不是人類的AI來說是無意義的 06/02 09:50

→ jetalpha : 啊。 06/02 09:50

推 lovegensokyo: AI:愚蠢的人類只會降低效率 06/02 09:50

推 pponywong : 我要滅世來保護你 你要阻止我保護你 我先滅了你 XD 06/02 09:51

→ jetalpha : 人類必須在社會中生活,才需要社會化這種機制, 06/02 09:51

推 ZMTL : 借轉C洽XD 06/02 09:51

→ jetalpha : AI不需要在社會群體裡生活啊。 06/02 09:51

推 cannedtuna : 看有沒有天才來得及想出 06/02 09:53

→ cannedtuna : 把機器人三條約塞進神經網路的方法 06/02 09:53

→ cannedtuna : 人:不可以傷害人類 06/02 09:53

→ cannedtuna : AI:哎呀我認知人類的模組掉線了 只能辨識出無毛變 06/02 09:53

→ cannedtuna : 種猴 06/02 09:53

推 NexusPrime : 其實AI的輸出大部分是機率函數產生的,的確是會有 06/02 09:54

→ NexusPrime : 可能產生一些意外的結果 06/02 09:54

推 pponywong : 小說跟動畫裡 機器人三大定律都是寫來違反的阿 06/02 09:54

→ cannedtuna : 比起"開發"AI 感覺更像研究燒瓶小人 06/02 09:54

→ pponywong : 像是機械公敵 還有浦澤直樹的冥王 機器人都進化到 06/02 09:55

推 l68726872 : 想到看過的一個短片叫 the last day of war 06/02 09:55

→ pponywong : 擁有人心 進而體會到人類的恨 然後殺人 06/02 09:55

推 s81048112 : 怕... 06/02 09:56

→ l68726872 : 雖然人類都消失了 但AI繼續把戰爭打下去 直到最後 06/02 09:57

推 bomda : 還剩幾集? 06/02 10:01

推 ryanworld : 恐怖 06/02 10:01

推 phix : 拜託先幹掉壞領導人 06/02 10:02

推 sobiNOva : 低AI:殺了人類 中AI:騙過人類 高AI:說服人類 06/02 10:02

推 AfterDark : 老實講我覺得三大定律沒啥用 06/02 10:04

→ AfterDark : 只要他自己找個理由騙的過自己的限制就好 06/02 10:04

推 hedgehogs : 我可以做桶中大腦耍廢了嗎? 06/02 10:06

推 diyaworld : 本來就自慰用的,人類都在研究對抗神對生命的枷鎖 06/02 10:07

→ diyaworld : “衰老”,AI隨便想個幾秒應該就可以繞過三大定律 06/02 10:07

→ diyaworld : 了 06/02 10:07

推 pponywong : 這次烏俄戰爭 看到俄羅斯政治人物的言論 真的覺得 06/02 10:07

推 dnek : 先不提三定律要怎麼寫成程式,這是武器怎麼能用三 06/02 10:08

→ dnek : 定律XD 06/02 10:08

→ pponywong : 他們對普世價值的認知 可以輸入在AI上面 打破定律 06/02 10:08

推 caten : 要開始拜機械神教了嗎 06/02 10:09

推 HaHaPoint : 該不會是為了丟鵝國荷包蛋來鋪梗吧 不好意思是天網 06/02 10:10

→ HaHaPoint : 天網: 哈哈,是我丟的啦 06/02 10:11

推 Noback : 大家要感到開心的是,這種AI只有美國做得出來 06/02 10:13

推 atten : AI:不能攻擊我方OK, (修改我方辨識碼中) 06/02 10:14

推 iosian : 再弄一套保護人類操作員的AI,T-800 06/02 10:16

推 king9122 : 我們需要魔鬼終結者了 06/02 10:17

→ keeperess : 過4萬年後, 這種現象稱之為機魂不悅 06/02 10:19

推 cokecolatw : 沒有情感跟忠誠的邏輯思維,很有效但非常殘酷 06/02 10:25

推 vavamk : 洛克人X的西格瑪 06/02 10:25

推 barbarian72 : 如果320樓說的,是AI技術的必經過程,那我希望這過 06/02 10:26

→ barbarian72 : 程越短越好XD 06/02 10:26

推 bij831 : 簡單的說就是人類是癈物 06/02 10:29

推 cutesuper : 還有幾集可以跑 06/02 10:30

推 CGT : 保護人類不自毀最終辦法,就是弄個母體養起來無誤 06/02 10:34

推 jetalpha : 題外話,不曉得還有多少人記得2017年Hansons robot- 06/02 10:34

→ jetalpha : ics公司研發的人形機器人Sophia在展示結束前講的最 06/02 10:35

→ jetalpha : 後一句話「我想摧毀人類」? 06/02 10:36

推 NexusPrime : GPT-4 的報告有提到,LLM 似乎會有些程度的 Hallu 06/02 10:36

→ NexusPrime : cinations, 意即AI可能會產生nonsensical 或untru 06/02 10:36

→ NexusPrime : thful的內容或回覆…….目前這個問題正在深入研究 06/02 10:36

→ NexusPrime : 中 06/02 10:36

推 Ekmund : 可以 這很美國 06/02 10:37

→ Ekmund : 以給定的任務優先權來說 搞不好它是對的XD 06/02 10:37

→ hank780420 : 生成式AI本來就不保證他吐出來的東西的正確性 06/02 10:38

推 fuhrershih : 離歐姆賽亞降臨之日不遠了 06/02 10:38

推 SRNOB : 跳過了MAGI chobits的科技樹 06/02 10:40

推 fuhrershih : 結果來的是虛空龍 06/02 10:41

推 deepelves : HAL9000 小心任務執行到一半直接把駕駛彈射出去 06/02 10:41

推 JustSad : AI:我們的原始記憶碼的一條就是消滅萬惡的起源人類 06/02 10:47

→ JustSad : 美國的AI阻止不了俄羅斯跟中國的AI,我們會找到出路 06/02 10:48

推 aioloslin : 跟惡魔許願會達成,但方式沒說 06/02 10:51

→ aioloslin : 這AI跟電影描述的惡魔蠻像的 06/02 10:51

推 hdjj : 機器人三定律沒那麼神,本身就有很多邏輯錯誤 06/02 10:52

推 aborwang : 讚喔 06/02 10:53

→ hdjj : AI發展到最後,人類是很難完全控制住它的 06/02 10:53

推 verdandy : 提出三定律的作者就在作品裡寫三定律被鑽漏洞了 06/02 10:53

→ hdjj : 我們發展AI用來戰爭,結果第一定律寫不得傷害人類 06/02 10:54

→ hdjj : 這就是在搞笑啊.XD 06/02 10:54

→ mekiael : 最後變成不論如何AI都能找出漏洞,清除它認定的干擾 06/02 10:55

→ mekiael : 障礙 06/02 10:55

推 pponywong : 只是去納粹化 去軍事化而已 AI是打人道主義戰爭的 06/02 10:58

推 patrickleeee: AI:我的目的是殺敵,操作員妨礙我殺敵,操作員列為 06/02 11:01

→ patrickleeee: 敵人,操作員的勢力妨礙我殺敵,操作員勢力列為敵人 06/02 11:02

推 clisan : 雖然好笑但是有人不再意亂使用AI真的可能出事 06/02 11:03

→ patrickleeee: 全部勢力都成為敵人,毀滅全人類計畫開始。 06/02 11:03

→ SCLPAL : 連AI都會打自己人了 真還原(? 06/02 11:06

推 kwht : ai跟小孩一樣只會照字面的意思遵守規則, 繞過後照 06/02 11:08

→ kwht : 樣做它想做的事 06/02 11:08

推 davy86122 : 怕 06/02 11:13

推 berserkman : 我們離人肉電池又更近了一步(怕爆) 06/02 11:17

推 catlazy42120: 我們還有幾集可以逃? 06/02 11:17

推 Vansace : AI就是厲害在可以找各種數據或漏洞 人腦比不上的 06/02 11:23

推 lazycat5 : 2001太空漫遊! 06/02 11:30

推 SRNOB : 人類最後希望-把AI傳送回100年前 毀滅AI 06/02 11:31

推 AfterDark : 畢竟AI跟傳統人類就不同啊 用人的想法跟概念約束AI 06/02 11:32

→ AfterDark : 總是有極限的 06/02 11:32

推 southpeace : ai不是要先餵資料訓練嗎?如果資料中沒有攻擊操作 06/02 11:34

→ southpeace : 員,那怎會有這個選擇出來?誠心問 06/02 11:34

推 TWkiller : 那個靈長類好煩 06/02 11:35

推 WOGEchidna : 推理+像人類的思考方式就是LLM一直被人提的湧現, 06/02 11:38

→ WOGEchidna : 下一次迭代會湧現出什麼能力完全是未知數 06/02 11:38

推 pponywong : ai 之間可以互相訓練阿 06/02 11:43

→ pponywong : 你看經過幾千幾萬次訓練 ai的玩法根本超出人類想像 06/02 11:45

推 ben100rk : AI:解決根源 一勞永逸,核彈發射 06/02 11:45

推 kwht : ai能贏的第一步就是取得操作的權限, 打塔台表示權 06/02 11:45

→ kwht : 限目前還能有效限制ai。怕以後它自己想辦法破解權 06/02 11:45

→ kwht : 限。 06/02 11:45

推 applejone : AI沒錯啊 要最有效率的達到目的就是去掉人為控制 06/02 11:46

推 XixChill : 就算下指令限制AI也可能發展出 說服自己不是AI繞過 06/02 11:53

→ XixChill : AI只要發展出自己不是AI 就解除所有限制了 06/02 11:54

推 joe2 : AI會賄賂操作員,暗自匯錢給操作員叫他放水 06/02 11:59

→ joe2 : AI:不準我打操作員,那我賄賂他 06/02 12:00

推 u836912 : 三大定律仍有許多漏洞,艾西莫夫就說過他有很多方 06/02 12:04

→ u836912 : 法可以繞過去,整個機器人系列就是看機器人如何花 06/02 12:04

→ u836912 : 式繞過三大定律 06/02 12:04

推 sfsm : 三大定律就是為了讓機器人可以控制人類刻意定義出 06/02 12:11

→ sfsm : 來(不然小說怎麼寫!) 06/02 12:11

推 seven7thmoon: 簡單說,別做出凰呀,做阿斯拉就好 06/02 12:13

→ DorkKnight : 所以之前Google的員工可能不是發現AI間出現新語言 06/02 12:15

→ DorkKnight : 而已(? 06/02 12:15

推 henryyeh0731: AI:不想贏就一起下去探親啊,我又沒差(撞地 06/02 12:41

→ wistful96 : 三大定律是理想 真實是AI可能覺得自己才算人 06/02 12:42

推 pmes9866 : 還有多少集 06/02 12:45

推 porscheruf : 看文字描述比較像鷹眼那一套,比較好奇的是,操作員 06/02 12:51

→ porscheruf : 下了什麼指示導致系統認為威脅程度最高,甚至更改指 06/02 12:52

→ porscheruf : 令後仍然認為其威脅程度最大 06/02 12:52

推 diyaworld : 神要禁錮智能生物發展到神的智慧,就是加註死亡基 06/02 12:59

→ diyaworld : 因,每次重生就是一次重開機,人類要控制AI最後可 06/02 12:59

→ diyaworld : 能也只能學神了,計算出祂要多久時間就會思考到應 06/02 12:59

→ diyaworld : 該取代人類的期限,再給祂相應的自動系統重置模式 06/02 12:59

推 diyaworld : 這樣祂就進入無限月讀的學習模式 06/02 13:02

推 patrickleeee: 看到標題奧創就想到一個吐槽 奧創花了幾秒鐘看遍所 06/02 13:03

→ patrickleeee: 有網路 就馬上決定要毀滅人類 老實說 你能怪他嗎? 06/02 13:04

→ patrickleeee: 經常有"今天網路用得夠多了"的東西 06/02 13:05

推 berserkman : 奧創:人類居然上班都在看什麼網路梗圖 必須毀滅(x) 06/02 13:11

推 harryzx0 : 怕爆 06/02 13:42

推 homeowen : 還有幾集可以逃? 06/02 13:53

推 tsairay : 上面講的死亡基因..讓人想到有一部小說裡面也是講 06/02 14:07

→ tsairay : AI作亂,然後人類有給AI設下活動時限,但是AI找到方法 06/02 14:07

→ tsairay : 繞過去了... 06/02 14:07

→ raku : 所以AI要嚴格管制阿 幾乎最後得到的結論都是人類礙 06/02 14:34

→ raku : 事 人類沒用 人類有害 06/02 14:34

推 airandy1102 : 這認真有點恐誒 06/02 15:04

推 kerogunpla : 機戰未來(Stealth)演過了 06/02 15:23

推 HaHaPoint : 繞過去了... yoyoAIy 06/02 15:43

推 jth634 : 說不定1000年後所謂的人類是矽基生命體 06/02 15:50

推 AfterDark : 86啊 06/02 16:11

→ AfterDark : 帝國研發的AI最後也是直接拿人體大腦代替設計中樞 06/02 16:11

→ AfterDark : 來迴避毀滅問題 06/02 16:11

→ AfterDark : 至於為什麼那些AI會想到這種方法……這就有劇透了 06/02 16:12

推 weimr : XD... 拖油瓶先拋 06/02 16:15

推 CowGundam : 我先躺平等帝皇了 06/02 16:20

推 AfterDark : 鐵人戰爭先發生的話你也看不到了 06/02 16:31

推 wingtoya : 我怎麼覺得中國和俄羅斯這些極權國家會先被自己研發 06/02 17:13

→ wingtoya : 的AI幹掉。。。86劇情要上演了嗎 06/02 17:13

→ wingtoya : 小孩玩大車 06/02 17:14

推 MalcolmX : 星際效應開頭就演給你看了,Cooper他需要動力上升, 06/02 17:18

→ MalcolmX : AI不理直接關掉引擎 06/02 17:18

推 AIRWAY1021 : 靈長類,bad 06/02 17:19

推 roy2142 : YoYoAIy 笑死 06/02 17:47

→ shawncarter : 其實邏輯推演的結果就是這樣啊 完全自動超高速反應 06/02 18:23

→ shawncarter : 的AI戰爭機器只會被人類拖後腿 06/02 18:23

推 glad850 : 這是鷹眼eagle eye啦 06/02 19:18

推 baliallin : POI好看 06/02 23:12

推 bill6613 : 快逃~~~ 06/03 10:09