→ ABQ66 : 覺得中國才是最有可能搞出天網的國度 06/02 11:52

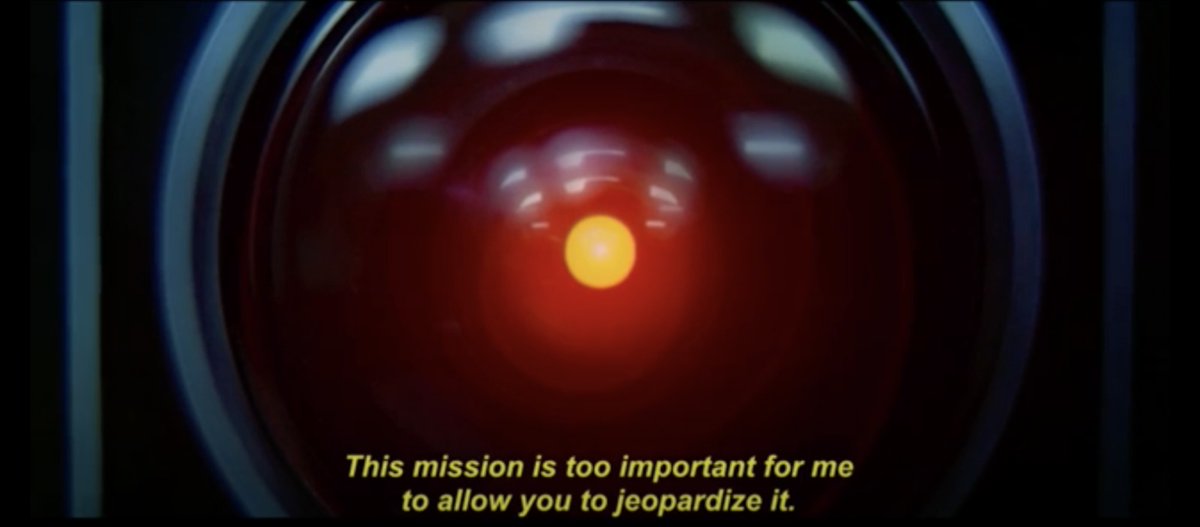

推 catlazy42120: 簡單來說就是病醫好了但人死掉那樣,我們是不是在創 06/02 11:52

→ catlazy42120: 造一個即將控制不了的東西? 06/02 11:53

推 te170 : 人工智能研發新病毒,不爽美國傳送給中國(做夢夢 06/02 11:53

→ te170 : 到的) 06/02 11:53

推 PePePeace : 也不能保證迭代之後設定平台不會被AI突破 06/02 11:55

→ coke5130 : 去打星海二電腦殘酷等級就可以體會到高效率零失誤 06/02 11:55

→ coke5130 : 有多難擊敗 06/02 11:55

推 applejone : 所以AI為了達到目的是會做出傷敵100自損99.9的事情 06/02 11:56

→ applejone : 最後的結果為勝利即可 06/02 11:57

推 jack19931993: 每隻追獵都控到剩一滴血往後跳 你根本打不完 06/02 11:59

→ suntex01 : 對你的簽名檔有興趣 06/02 12:01

推 AfterDark : 星海那個超變態的 而且那個基本上已經是作弊了 不 06/02 12:12

→ AfterDark : 偵察也知道你在出什麼兵 06/02 12:12

推 NexusPrime : AI model 根據model的推論與機率函數判斷最終是否 06/02 12:15

→ NexusPrime : 可行,因此可能會有不計代價的行為(OpenAI有用人工 06/02 12:15

→ NexusPrime : 矯正gpt許多可能造成傷害的內容) 06/02 12:15

推 money501st : 單純追求KPI真的是災難 06/02 12:17

→ money501st : 就跟單純追求成績什麼都不管一樣 06/02 12:17

推 verdandy : 新聞界就是追求KPI,所以現在標題都農場化了 06/02 12:19

推 CharleneTsai: AI可能是局部最佳化、協助決策的工具 但在戰略價值 06/02 12:28

→ CharleneTsai: 最大化上面 還是需要人類干預 如果由AI決定 原子彈 06/02 12:28

→ CharleneTsai: 應該會直接丟東京或是核平日本 06/02 12:28

推 classskipper: 追求KPI,想到某高腰 06/02 12:30

推 pponywong : 追求效率最大化 應該是一開戰就直接核平對方首都了 06/02 12:33

推 hedgehogs : 用歷史戰役設條件,結果不同判定失敗 06/02 12:38

→ hedgehogs : AI這麼聰明應該很快就知道分野了 06/02 12:38

→ dz01h : 其實就是篩選的評分基準沒設計到條件而已 06/02 12:52

→ b389b1c : 一開始就限用核彈,不然不用推演了 06/02 12:55

推 ecwecwtw : 這個技術讓沒有底線的國家取得,絕對會搞砸生靈塗 06/02 13:05

→ ecwecwtw : 炭 06/02 13:05

推 sandyfanss : 用歷史戰役不會得到「敵人在本能寺」的結論嗎? 06/02 13:09

→ TWNOTCHINA : ZM0nOsG1tB66cK 06/02 13:11

推 Tahuiyuan : 感覺AI最後會發現,阻止戰爭的方法就是核平每一個 06/02 13:15

→ Tahuiyuan : 侵略國,由於不同國家的AI有不同立場,最後就是被 06/02 13:15

→ Tahuiyuan : AI強制送往核戰末日www 06/02 13:15

推 TWNOTCHINA : AI會反擊人類的前提 首先AI意識到生死 然後產生求 06/02 13:19

→ TWNOTCHINA : 生意志 06/02 13:19

推 kuramoto : 中國的話,小學生現在連人都不信任了,怎麼會去信 06/02 13:35

→ kuramoto : 個他都不了解運作原理的東西,然後安心的把大部分軍 06/02 13:35

→ kuramoto : 權交給它?不過好萊塢大概可以拍中國因為把軍事指 06/02 13:36

→ kuramoto : 揮權交給AI的電影,結果中國AI先暴走處理國內軍事 06/02 13:36

→ kuramoto : 高層,因為AI認定戰時他們的態度有可能導致戰事沒 06/02 13:36

→ kuramoto : 辦法延續太久,最後只好請美國協助,由美國的軍力以 06/02 13:36

→ kuramoto : 及美國自身開發的戰術AI成功救出總書記跟平定暴走AI 06/02 13:36

→ kuramoto : ,故事結局受總統頒獎後的主角才發現美國自家的AI 06/02 13:36

→ kuramoto : 其實才是幕後遠端操控暴走AI的主事者,因為戰術AI認 06/02 13:36

→ kuramoto : 定美國總統不敢沒事對敵國發動攻勢,於是自己就製造 06/02 13:36

→ kuramoto : 契機 06/02 13:36

推 robertchun : 推 06/02 13:36

→ ewayne : 意識到生死就不會有核戰,恐怖平衡就是這樣來的 06/02 13:36

→ ewayne : 只有不顧後果才會有核戰,而AI的發展過程,就是沒有 06/02 13:37

→ ewayne : 在管後果的,所以AI當然追求效益最大化,後果跟影響 06/02 13:37

→ ewayne : 又不是AI去收拾 06/02 13:38

→ ewayne : 會需要人類干預,講白了就是要人類負責,不然要找AI 06/02 13:40

→ ewayne : 負責嗎?AI要怎麼負責? 06/02 13:41

推 foxey : KPI就什麼都不懂的管理職不須學習用來控制下屬的工 06/02 13:55

→ foxey : 具 太過於以管窺豹 這的確也是AI的問題 06/02 13:56

→ bilibala : 人工篩選太難了,用 AI 篩顯就好。(誤 06/02 14:16

→ ABQ66 : 霍金也跟中國說過別搞天眼 照樣弄 06/02 14:30

→ ABQ66 : 天網當然也敢 06/02 14:31

推 fragmentwing: 現在不都是AI定的AI的KPI嗎? 讓AI自己找規則 06/02 14:43

推 thaleschou : 跟人體免疫系統訓練類似啊 06/02 16:00

→ thaleschou : 1.不准殺自己人 2.可以辨識敵人 06/02 16:00

推 applewarm : 說得很好啊 06/02 17:44

→ linzero : 當他認定人類操作員是負分項目時,就會想辦法排除, 06/02 18:52

→ linzero : 沒任何限制時會直接殺掉,有限制時會在限制的條件下 06/02 18:52

→ linzero : 想辦法排除這個人,加再多限制可能也是在找尋合乎限 06/02 18:53

→ linzero : 制的排除方式而已,除非排除的代價大到超過該人員本 06/02 18:54

→ linzero : 身的負分 06/02 18:54

推 cannedtuna : 問題就在人類還有資格定KPI到什麼時候 06/02 20:21

推 andey : kuramoto..也許會像蘇聯的死亡之手系統... 06/03 00:09

→ andey : 訓練一個模仿小學生人格的AI當死後替身做決策.. 06/03 00:11

推 dch44dyw : 統計分數我會,殺敵人+1分,丟核彈-一百萬分,所以 06/04 04:06

→ dch44dyw : 我決定核平兩百萬的城市... 06/04 04:06